SOLUCIONESAUSTRAL

miércoles, 16 de marzo de 2022

Ciencia de datos, un ejemplo en salmonicultura.

Ciencia de datos, un ejemplo en salmonicultura.

Estimadas y estimados colegas, junto con saludar, les comparto un breve análisis sobre los resultados obtenidos en producción de salmones (Salmo salar) durante 10 años (2008 a 2018).

Para entender los gráficos de caja, estos muestran el promedio (línea oscura dentro de la caja) y la desviación estandar, lo que representa la caja y finalmente los out liers.

El análisis del grafico superior muestra la ineficiencia o mayor pérdida de producción (mortalidads totales) para cada ACS (universo total de ACS por 10 años), tipicada con un código ( 1, 2,,....,n).

El análisis del gráfico inferior muestra la ineficiencia o pérdida de producción (mortalidad total) para cada una de las empresas de salmones que produjeron salmones durante el período mencionado (Universo total de empresas salmoneras por 10 años, codificadas desde 1,2,...n).

Como pueden ver, es posible identificar las zonas de mejor eficiencia productiva y también es posible observar cuales son las empresas que tienen mejor eficiencia productiva ( las que tienen menos valor en la escala de 1 al 100).

Cabe mencionar que este análisis se puede realizar para cada centro de cultivo, relacinado a su empresa y al área (ACS) en el timepo.

Lo más interesante de este análisis realizado en R, es que si agregamos los datos ambientales (oceanográficos, climáticos y biológicos), podremos conocer los efectos en la producción o más bien conocer que elementos considerar para obtener una mayor eficiencia productiva. Incluso, si es que se tuviese la información, se puede correlacionar tipos de alimento, cantidades entregadas, etc. para intentar generar un modelo de producción, ya sea predictivo o correctivo.

Espero que lo anterior les haya sido de interés. Y si necesitan realizar un análisis de este tipo o similar, no duden en contactarme, tal vez les pueda ser de ayuda.

saludos.

Nota: ACS corresponde a Agrupación de Concesiones de Salmón.

Los datos coresponden a la producción de Salmo salar durante 10 años en Chile, desde 2008 a 2018.

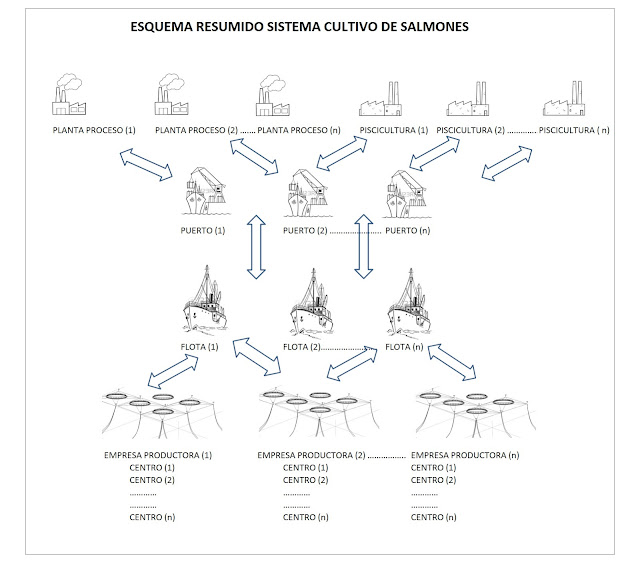

Teoría de Juego en Salmonicultura en Chile

Teoría de Juego en Salmonicultura en Chile #gametheoryEstimadas y estimados colegas, Junto con saludar, quisiera compartir con ustedes algunas reflexiones a partir de un estudio que realicé no hace Mucho. En primer lugar les comento que a partir del análisis de 10 años de información de la acuicultura de salmones en Chile (Cantidad de peces sembrados, cantidad de peces cosechados de todas las empresas de Chile, por mes y año), fue posible encontrar una relación basada en Teoría de Juegos.

Dicha relación muestra que la mayor probabilidad de obtener menores pérdidas por mortalidad de peces se da en un rango determinado de ingreso de peces en la siembra. Esto quiere decir, que si en cada agrupación de centros de cultivo o áreas en particular, los jugadores (empresas productoras) deberían tener un límite global de ingreso de peces y de esta manera poder asegurar una mayor eficiencia en la producción.

Esto es algo similar a lo que se hace con la pesca compartida entre países o algunas recomendaciones sanitarias que se hacen en Escocia.

Lo anterior se presenta en el esquema adjunto, en el cual la curva azul representa la probabilidad de menor costo y la curva roja representa la pérdida por muerte de salmones para una determinada cantidad de salmones sembrados.

lunes, 5 de octubre de 2020

Data Analysis

Data

Analysis

Hace mucho tiempo, cuando aprendí a programar

en Fortran IV, se nos enseñó el axioma GIGO (garbage in, garbage out, propuesto por George Fuechsel en los 60’s).

Los nuevos sistemas de Big Data, inteligencia

artificial u otros, dependen de los datos de origen. Sí estos son erróneos,

sesgados o incompletos, no aseguran resultados confiables o útiles.

El axioma GIGO es un concepto fundamental de

las ciencias de la computación para verificar el rendimiento apropiado del

análisis de datos o proceso de software. (sin considerar que depp learning nos

ayuda a con el concepto GIGO). Este axioma nos

hace preguntarnos sobre los datos presentados: son completos?; están al

día?; podemos confiar en ellos?, son influidos por el prejuicio, las

suposiciones o por la perspectiva limitada?. Son exactos, son pertinentes y son

verdaderos?

Por otra parte debemos convalidar el rendimiento

obtenido de nuestro proceso de análisis, verificar los resultados para ver si

tienen sentido. Verificar si los resultados tienen sentido, si reflejan las

expectativas y si son contra intuitivos y por qué?.

Los resultados tienen una tendencia clara que

se observa en resultados anteriores? o en procesos similares?, se pueden

comprobar usando otros métodos?

En los últimos años se ha masificado el uso

de análisis de Big Data, AI, Machine Learning, Deep Learning, Neural Networks.

Sin embargo es necesario entender la naturaleza de los resultados, entender la

naturaleza del origen y donde la

plataforma es secundaria. Los sistemas no pueden saber cuál es la calidad

de los datos, es por ello la importancia del análisis de datos.

El concepto

primordial del análisis de datos es transformar los datos en ideas procesables.

Si no se

puede medir algo no se puede mejorar, por lo que es vital capturar datos,

guardar los datos antiguos y nuevos, para luego comenzar a analizarlos y así

obtener un resultado, una historia o una narrativa.

Lo importante del análisis de datos es que es

aplicable a todo tipo de procesos, fabricas, agricultura, pesca y acuicultura.

La cantidad de datos no es un inconveniente, ya que pueden ser pocos o muchos

los datos (incluso big data). Incluso se puede usar Excel, bases de datos

relacionales (acces, SQL), AI o Machine learning.

Finalmente quisiera comentarles que si no se

hace un examen exhaustivo de los datos, de nada nos servirá tener tecnología de

punta o complicados procesos de cálculo, ya que se cumplirá el axioma GIGO.

lunes, 14 de septiembre de 2020

Alineación de Procesos

Alineación

de Procesos

Uno de los proyectos en que estoy interesado

en el último tiempo, tiene que ver con revisar la alineación de los procesos

productivos con relación a la estrategia de una empresa en particular. Es claro

que las compañías sufren durante su existencia cambios o desalineaciones, ya

sea por protocolos que son cambiados o protocolos obsoletos o porque las

distintas áreas realizan sus actividades sin considerar los procesos definidos

en un principio para su operación o por falta de control sobre estos. El

diagrama que sigue nos muestra el proceso de obtención de resultados a partir

de la estrategia de la empresa y los posibles grados de desviación en el

resultado esperado.

Cuando la estrategia organizacional se aleja de la estrategia de negocio es un indicador de que hay una disminución de la productividad de la compañía, ya sea por el uso de tácticas poco efectivas o la falta de atención a las tácticas definidas para seguir la estrategia de la empresa. Es así, que estrategia organizacional y la gestión de procesos deben converger para alinearse y obtener el resultado esperado.

El proceso de revisión de la alineación debe

ser hecho en forma independiente y no en base a la documentación existente, porque

esta puede tener sesgo para cumplir las auditorías documentales y no

representar el resultado de las gestiones, sino que sólo de los procedimientos

a realizar.

Podemos ejemplificar diciendo que una

actividad debe hacerse (según el programa) con los siguiente pasos: A, B, C,

etc. Al analizar dichos pasos en la práctica, podemos saber si se hicieron o no

y un índice de valor de dicho resultado (KPI).

Pero el que se realice una actividad no nos

garantiza que el resultado es el esperado y dado el nivel de variabilidad de

una empresa, el valor del KPI también será errático, por lo que sin un análisis

detallado de que se espera y que se obtiene no podemos saber si hay una

desalineación en el proceso y por tanto resultados que no satisfacen la

estrategia.

Existen una gran cantidad de problemas que

generan desalineación, tales como:

1.

Dobles jefaturas en la cadena de mando

2.

Falta de preparación en los que toman decisiones

3.

Jefaturas que no siguen las indicaciones provenientes de las

gerencias

4.

Distintos síndromes tales como el Síndrome del “Gerente Medio”, el

Síndrome de “Dunning-Kruger”, Síndrome de “No inventado aquí”, Síndrome de “Procusto”

y otros tantos.

Sucede que mandos medios o jefaturas de

distintos niveles no necesariamente siguen las instrucciones o programas que

forman parte de las directrices principales o estrategia de la compañía.

Sin hacer un juicio de valor sobre las

motivaciones y razones por las que sucede, es un problema que se observa en

distintas empresas y organizaciones.

La información que reciben los directivos no necesariamente

se corresponde con los datos obtenidos ya sea por sesgo de los datos, datos

incompletos o datos modificados.

También hay problemas con el uso de KPI que

no otorgan información útil o usar demasiados KPI, ya que los KPI deben estar

en función de la estrategia.

Debido a la desalineación, nuestros

resultados esperados se tornan erráticos, lo que hace que el desempeño sea

negativo o excesivamente positivo (lo que también es malo), afectando la

rentabilidad del negocio. La variabilidad en el tiempo de los resultados puede

ser permanente, puntual, continua o discontinua. Esto nos indica la necesidad

de una vigilancia continua y permanente.

Los efectos en los costos de operación y

administración obtenidos por diferentes resultados en la gestión pueden

afectar, como ya se mencionó la rentabilidad ya sea por efectos en los costos

marginales, ingresos, y costos en general. E incluso obteniendo ingresos

desalineados.

Una manera de mejorar el problema que se

presenta al tener un proceso desalineado

es, rediseño de estándares, medición de calidad, conocer cuál es la

diferencia entre la desalineación y los resultados esperados a partir de la

estrategia.

Dado lo anterior, es que creo es necesario

implementar un revisión permanente del desarrollo de los proyectos o procesos,

para poder corregir el des-alineamiento que se pueda generar durante la vida de

la compañía o de un proyecto en particular.